La línea que separa la concienciación de la explotación es más estrecha que nunca, y la IA la está cruzando.

La inteligencia artificial está transformando las industrias a una velocidad acelerada, y el sector benéfico no es la excepción. Desde la redacción automatizada hasta las imágenes generadas por IA, las organizaciones experimentan con nuevas herramientas para contar historias y conectar con los donantes. Pero a medida que estas tecnologías avanzan, también plantean interrogantes complejos. Cuando se crean digitalmente rostros de niños necesitados, ¿de quién es la historia que se cuenta y a qué precio?

En este artículo, exploramos el uso cada vez mayor de imágenes generadas por IA en el sector de la ayuda y el desarrollo. Si bien estas imágenes pueden ser impactantes, también conllevan serios riesgos éticos, especialmente cuando se adentran en el ámbito de “porno de la pobreza”, «Convertir el sufrimiento humano en un espectáculo». En Children Change Colombia, creemos que hay un mejor camino. Nos centramos en historias reales, niños reales e impacto real, utilizando imágenes y fotografías auténticas para mostrar las vidas que apoyamos y la alegría que nuestros proyectos ayudan a cultivar, incluso en circunstancias difíciles.

También compartimos orientación práctica para organizaciones benéficas y simpatizantes: cómo crear comunicaciones que inspiren en lugar de explotar y cómo las audiencias pueden aprender a identificar narrativas poderosas que no recurren a atajos artificiales.

El auge de las imágenes generadas por IA en la ayuda y el desarrollo

Por Stephany de Cohen

El sector de la ayuda y el desarrollo a nivel mundial lleva tiempo debatiendo la ética de la narrativa visual. El tradicional «pornografía de la pobreza» ha sido ampliamente condenado, lo que ha dado lugar a normas más estrictas que desalientan las representaciones deshumanizantes o sensacionalistas. Sin embargo, el rápido auge de la IA generativa está reabriendo viejos debates e introduciendo nuevas complicaciones.

Un análisis de 2025 sobre comunicación en salud global, realizado por Arsenii Alenichev y sus colegas, destaca cómo la IA generativa permite ahora a las organizaciones producir imágenes altamente emotivas en segundos y a un coste mucho menor que el de encargar fotografía. Ante la reducción de presupuestos en todo el sector, esta tecnología resulta cada vez más atractiva. Sin embargo, muchas de estas imágenes sintéticas reproducen precisamente los estereotipos que las directrices éticas pretendían prevenir. Dado que no interviene ninguna persona real, algunas organizaciones utilizan la IA como una escapatoria legal; una justificación para recrear estereotipos explotadores que evitarían con sujetos reales.

Esto resulta especialmente preocupante porque las imágenes hiperemotivas generadas por IA —niños hambrientos, familias angustiadas, «pueblos» rurales ficticios— pueden, por sí solas, perjudicar campañas de recaudación de fondos. Las organizaciones más pequeñas, sobre todo las de países de ingresos bajos y medios, se ven atraídas porque las expectativas de los donantes siguen estando fuertemente influenciadas por una perspectiva occidental acostumbrada a las campañas de impacto. Mientras tanto, las grandes tecnológicas ya se benefician de esta dinámica. El mercado de Adobe, por ejemplo, muestra imágenes generadas por IA de cuerpos negros y morenos en estereotipos de pobreza, ilustrando cómo el sufrimiento se mercantiliza y se estetiza.

A pesar de los crecientes riesgos, no existen directrices sectoriales vinculantes que regulen las imágenes generadas por IA. Con la reducción de los presupuestos y la proliferación de herramientas de IA, es probable que las representaciones sintéticas de situaciones de adversidad se vuelvan aún más comunes. Para comprender por qué esto es peligroso, debemos considerar las imágenes generadas por IA como el capítulo más reciente de una historia mucho más larga de comunicación visual problemática en el sector de la ayuda humanitaria y reconocer la rapidez con la que pueden revivir narrativas dañinas que muchos se han esforzado por desmantelar.

Los riesgos éticos

Por Diego Mojica

El creciente uso de imágenes generadas por IA en campañas humanitarias ha suscitado una profunda preocupación ética entre defensores, activistas y comunidades de todo el mundo. Lo que antes se presentaba como una herramienta para mejorar la eficiencia ahora se cuestiona por cómo distorsiona las experiencias humanas reales, sobre todo en torno a temas tan delicados como la pobreza, el hambre y la violencia.

Un informe de 2025 por El Guardián enfatizó que las representaciones de sufrimiento generadas por IA a menudo refuerzan estereotipos dañinos, tergiversan la realidad y anulan el consentimiento y la dignidad de las personas cuyas imágenes o circunstancias se reproducen. A medida que las imágenes generadas por IA saturan los mensajes humanitarios, corren el riesgo de erosionar la confianza pública y acelerar la fatiga de los donantes, reduciendo realidades complejas a imágenes deshumanizantes diseñadas para generar un impacto emocional.

Estereotipos dañinos y tergiversaciones

Las herramientas de IA suelen distorsionar la realidad de lugares como Colombia, reforzando narrativas obsoletas sobre el “sur global empobrecido”. Las búsquedas de imágenes de “pobreza” generadas por IA en plataformas como Freepik a menudo muestran personas no blancas en entornos exagerados o exotizados: refugios improvisados, caminos de tierra, imitaciones distorsionadas de vestimenta “tradicional” y expresiones teatrales de desesperación. Incluso, cuando aparecen personas blancas en estas imágenes, suelen vestir estilos de ropa apropiados de África, Latinoamérica, Oriente Medio o el sur de Asia, lo que refuerza una idea homogeneizada de la pobreza como algo inherentemente “no occidental”.

La representación del voluntariado también está sesgada: las imágenes generadas por IA presentan mayoritariamente a quienes ayudan como blancos y a quienes reciben la ayuda como negros o morenos. Esto revive narrativas dañinas del salvador que privan a las comunidades del Sur Global de su capacidad de acción.

Consentimiento, dignidad y “fotografías robadas”

Una defensa común de las imágenes generadas por IA es que las personas representadas “no son reales”. Pero los sistemas de IA se entrenan con millones de fotografías reales, incluidas algunas poco éticas o no consensuadas. CNN informó en 2016, el ex fotógrafo del New York Times, Chester Higgins Jr., reveló que muchas imágenes de organizaciones benéficas y ONG eran históricamente “fotografías robadas”: imágenes tomadas en momentos vulnerables sin consentimiento.

Los modelos de IA se basan en enormes conjuntos de datos que casi con seguridad incluyen este tipo de imágenes, lo que da como resultado imágenes sintéticas construidas a partir de fragmentos del sufrimiento de personas reales. En lugar de reproducir una sola fotografía ilícita, la IA combina elementos de innumerables fotografías robadas, creando un collage de imágenes sin consentimiento que se hace pasar por una composición anónima.

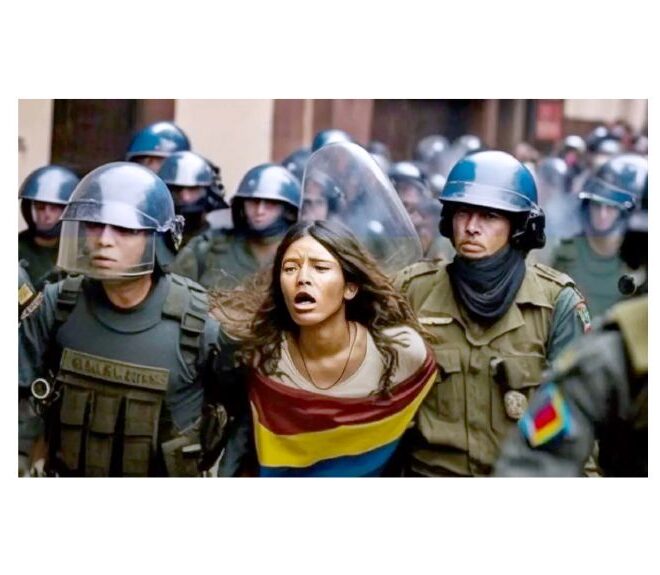

Daño reputacional y fatiga del donante

Los riesgos no son solamente éticos, sino también reputacionales. Cuando Amnistía Internacional utilizó imágenes generadas por IA para promocionar un informe sobre las protestas en Colombia en 2021, la reacción negativa fue inmediata. Los espectadores cuestionaron la credibilidad del informe; si las imágenes eran falsas, ¿cuán fiable era el contenido? En un contexto donde la desinformación se propaga rápidamente, el uso de imágenes sintéticas socava la confianza en las narrativas humanitarias. Al mismo tiempo, el sensacionalismo generado por la IA que explota la pobreza contribuye a la fatiga de los donantes. La exposición constante a un sufrimiento dramático y descontextualizado insensibiliza al público, convirtiendo las dificultades reales en un espectáculo que entretiene en lugar de movilizar. A medida que las imágenes generadas por IA se vuelven más comunes, es probable que esta fatiga —y el escepticismo— se intensifiquen.

Lo que el anuncio navideño de Coca-Cola con IA nos enseña sobre el mal uso de las emociones

El anuncio navideño de Coca-Cola para 2025 es un claro ejemplo de lo que sucede cuando las marcas intentan manipular las emociones humanas mediante medios artificiales. En lugar de las imágenes cálidas y nostálgicas que la gente asocia con las fiestas navideñas, la empresa presentó una versión generada por IA de su clásica campaña “Se acercan las fiestas”, creada por el estudio de IA Secret Level. Pero en vez de capturar la alegría, la magia y la unión, el anuncio sumió a los espectadores en un extraño valle de criaturas con fallos gráficos, rostros distorsionados y camiones que parecían flotar de forma extraña, desconectados del mundo que los rodeaba.

Lo que pretendía generar confort acabó inquietando al público. Los comentaristas describieron a los animales generados por la IA en el anuncio como «inexpresivos», con proporciones deformadas y expresiones extrañas y oníricas. Una creación particularmente memorable, una criatura parecida a un perezoso con rasgos inquietantes, se convirtió involuntariamente en el símbolo de cómo la IA puede transformar la narrativa emocional en algo vacío y siniestro. Para una campaña basada en la nostalgia y la calidez, esta apariencia artificial y extraña contrastaba de forma chocante.

El problema no era sólo estético; era una disonancia emocional. Para muchas personas, el anuncio navideño de Coca-Cola es un ritual entrañable, parte de la magia de la temporada con un profundo significado cultural. Sustituirlo por imágenes generadas por IA eliminó el toque humano que da sentido a la Navidad. En lugar de asombro, los espectadores se quedaron con una sensación de cinismo, como si una junta directiva hubiera decidido que la esencia emocional de la Navidad se podría externalizar a un algoritmo.

Y es precisamente por esto que las imágenes generadas por IA son tan arriesgadas en el sector de la beneficencia y el desarrollo. Si la IA puede deshumanizar algo tan universalmente entrañable como la Navidad, las consecuencias son aún más alarmantes cuando se trata de sufrimiento humano real. Cuando las imágenes sintéticas sustituyen a las historias reales, ya sea en un anuncio navideño o en una campaña humanitaria, la conexión emocional se vuelve artificial, distorsionada y, en definitiva, poco fiable. Los espectadores perciben cuando algo no encaja, y esa desconexión erosiona la credibilidad y la empatía.

El anuncio de Coca-Cola demuestra que la IA no puede replicar la profundidad, la autenticidad ni la humanidad que provienen de personas y experiencias reales. Y en la comunicación de organizaciones benéficas, donde la dignidad, la verdad y la confianza son esenciales, esta lección resulta más que evidente.

Cómo Children Change Colombia cuenta historia de forma diferente

En Children Change Colombia, creemos que contar historias auténticas es fundamental para una comunicación ética. En lugar de recurrir a imágenes artificiales o representaciones sensacionalistas de las dificultades, utilizamos videos y fotografías reales de Colombia para mostrar el impacto tangible de nuestro trabajo. Esto no solo genera confianza en los donantes, al garantizar que vean a dónde van realmente sus contribuciones, sino que también honra la dignidad de los niños y las comunidades a las que servimos. Nuestro contenido refleja todo el espectro de las experiencias infantiles: los desafíos que enfrentan y la alegría, la resiliencia y la creatividad que nuestros proyectos ayudan a cultivar. Al mostrar esperanza junto con las dificultades, ofrecemos narrativas veraces y humanizadoras, nunca reduccionistas.

La imagen de marca juega un papel fundamental en este compromiso. Cada historia e imagen se alinea con nuestra misión, representando con precisión los problemas que abordamos y rechazando la tentación de explotar la pobreza. Si bien algunos argumentan que el contenido sensacionalista aumenta las donaciones, rechazamos firmemente este enfoque. Nuestra misión se basa en la transparencia y el empoderamiento: no podemos contar la historia de los niños y niñas de Colombia sin que sean niños y niñas reales quienes estén en el centro. Las imágenes generadas por IA también conllevan una idea errónea: que, al no estar representadas por personas reales, son éticamente más seguras. Sin embargo, la IA se entrena con imágenes reales, incluidas miles tomadas sin consentimiento. La idea de un «niño falso» es engañosa. Estas imágenes se basan en la semejanza de innumerables niños reales cuyas fotografías fueron obtenidas sin permiso.

Los niños y las comunidades con las que trabajamos nos enseñan a diario sobre las oportunidades y los desafíos que dan forma al futuro de Colombia. Silenciar sus voces con imágenes manipuladas sería tergiversar su realidad y nuestra misión. Como personas que se involucran con nuestro trabajo, ya sea por curiosidad o solidaridad, nuestro compromiso es brindar relatos verídicos, historias auténticas y representaciones honestas de las realidades que enfrentan los niños colombianos. El sensacionalismo de la pobreza mediante imágenes generadas por IA socava este propósito. Es una práctica poco ética, explotadora y profundamente desconectada de las experiencias vividas que buscamos reflejar. En CCC, nos enorgullece mostrar la realidad de la infancia en Colombia con integridad y respeto, demostrando que contar historias impactantes no requiere comprometer la ética.

Por qué el consentimiento importa: Proteger los derechos y la dignidad de cada niño

En Children Change Colombia, cada imagen que compartimos comienza con un principio innegociable: el consentimiento. Cuando aparecen niños en nuestras fotos o vídeos, obtenemos permiso por escrito de sus padres, tutores o adultos responsables. Esto no es un mero trámite, sino un compromiso con la defensa de los derechos, la dignidad y la seguridad de cada niño con el que trabajamos.

Pero el verdadero consentimiento va más allá de una firma. Nos aseguramos de que las familias entiendan exactamente cómo y dónde sus imágenes pueden utilizarse, ya sea en un informe, una campaña de recaudación de fondos o contenido para redes sociales. Y, lo que es importante, siempre se les informa. ¿Adónde ir si cambian de opinión? En cualquier momento, un padre, madre o tutor legal puede contactarnos para retirar su consentimiento, e inmediatamente dejaremos de usar esa imagen. Su autonomía y bienestar son siempre nuestra prioridad.

Este enfoque garantiza que nuestras historias se basen en el respeto, la transparencia y la colaboración; jamás en la explotación. Si bien las imágenes generadas por IA difuminan los límites de quién está representado y si alguna vez dio su consentimiento, nuestro trabajo se fundamenta en relaciones reales y en las voces reales de niños, niñas y familias. Al respetar el consentimiento en cada paso, no solo protegemos identidades, sino también la confianza.

Consejos prácticos: Cómo las organizaciones y audiencias pueden evitar los problemas de las imágenes generadas por IA

- 1. Prioriza la autenticidad sobre la estética: Las historias reales impactan más que las emociones generadas artificialmente. Siempre que sea posible, utiliza fotos, vídeos o citas reales de las comunidades con las que trabajas, con su consentimiento informado. La autenticidad genera confianza de forma mucho más eficaz que las imágenes perfectas creadas por IA.

- 2. Siempre indique las fuentes de las imágenes: Si se utiliza IA para diseño o ilustraciones (nunca para representar personas o situaciones de adversidad), debe indicarse claramente. La transparencia es fundamental. Los donantes y simpatizantes nunca deben tener dudas sobre si una imagen representa a una persona o situación real.

- 3. Sitúe la dignidad en el centro de toda comunicación: Pregúntate:¿Me sentiría cómodo si me representaran de esta manera? Evite imágenes que reduzcan a las personas a símbolos de sufrimiento, ya sea real o sintético. Represente a los individuos como agentes de cambio, no como víctimas pasivas.

- 4. Incorpore las revisiones éticas a su flujo de trabajo: Implementa una lista de verificación interna sencilla antes de publicar cualquier elemento visual. Por ejemplo: ¿Esta imagen refleja la realidad? ¿Podría reforzar los estereotipos? ¿Se obtuvo el consentimiento? ¿Podría un donante o un socio comunitario malinterpretar esto? Esto evita fallos accidentales, especialmente cuando los equipos están sobrecargados

- 5. Utilizar la IA como apoyo, no como narración: La IA puede ser útil para la traducción, la accesibilidad, la obtención de información para la recaudación de fondos o las plantillas de diseño. Pero nunca debe usarse para inventar dificultades, personajes o «niños representativos». Limitemos la IA a donde aporta valor, no a donde distorsiona la realidad.

- 6. Para los simpatizantes: Observen atentamente y hagan preguntas: Si la imagen de una organización benéfica parece demasiado dramática o extrañamente perfecta, puede que no sea real. Los simpatizantes pueden preguntar: ¿Es una fotografía o una imagen generada por IA? ¿El niño o la persona que aparece en la imagen es real? ¿Explica la organización benéfica la procedencia de sus imágenes? Las organizaciones éticas responderán con gusto y es posible que incluso lo divulguen de antemano.

- 7. Apoya a las organizaciones benéficas que dan voz a la comunidad: Busque organizaciones que muestran alegría, resiliencia y progreso junto con desafíos reales. Aquellas que colaboran verdaderamente con las comunidades rara vez necesitan tácticas impactantes o imágenes artificiales.

A medida que la IA continúa transformando la forma en que se crean y comparten las historias, el sector benéfico se enfrenta a un momento crítico. La tecnología ofrece herramientas poderosas, pero también presenta nuevas formas de perpetuar viejos errores; desde reforzar estereotipos hasta borrar las experiencias reales de las personas tras rostros sintéticos. Cuando las imágenes de pobreza o dificultades son generadas por un algoritmo, corren el riesgo de convertir la lucha humana en un producto: infinitamente editable, emocionalmente manipulador y ajeno a las comunidades que pretende representar.

En Children Change Colombia, creemos que el futuro de la narrativa ética reside no en atajos artificiales, sino en personas reales, voces reales y un cambio real. Los niños y las comunidades con las que trabajamos no son símbolos ni escenarios; son socios, líderes e impulsores de la transformación. Sus historias merecen honestidad, respeto y atención. Al optar por la autenticidad en lugar de la invención, la dignidad en lugar del dramatismo y la humanidad en lugar de la conveniencia, podemos reformar la forma en que el sector se comunica y restaurar la confianza en un momento en que más se necesita.

Ya sea que trabajes en el sector de las ONG, seas donante o simplemente te preocupe la representación responsable, tienes un papel que desempeñar para desafiar las narrativas dañinas y promover las éticas. Porque, al final, las historias impactantes no se basan en la imagen perfecta, sino en la verdad y en las personas cuyas vidas y futuros nos esforzamos por transformar juntos.

Escrito por Stephany de Cohen (CCC voluntaria), Diego Mojica (CCC Pasante), y Victoria Cornelio (Manager de Comunicaciones)